在硅谷度过了一个非凡的周末后,OpenAI 的前首席执行官萨姆·奥尔特曼 (Sam Altman) 胜利地回到了他的公司。Altman 与 OpenAI 董事会的摩擦在社交和传统媒体上引起了大量讨论,这些分歧被认为源于 OpenAI 与其控股公司盈利/非营利性质之间的分歧。然而,营利性做法可能并不是造成分歧的唯一原因,《纽约时报》的一份新报告指出,摩擦的一个关键根源是董事会成员海伦·托纳 (Helen Toner) 撰写的一篇研究论文。

Altman 下台的核心研究论文称 OpenAI 的“信号”方法不够充分

托纳女士是乔治城大学安全与新兴技术中心的主任,她在 10 月份撰写了一份案例研究,内容涉及政府和公司如何构建沟通以避免他人误解。这篇与乔治城大学相关人员共同撰写的论文定义了一种称为“信号”的通信工具,国家安全和人工智能太空参与者可以依靠这些工具来澄清他们的意图。

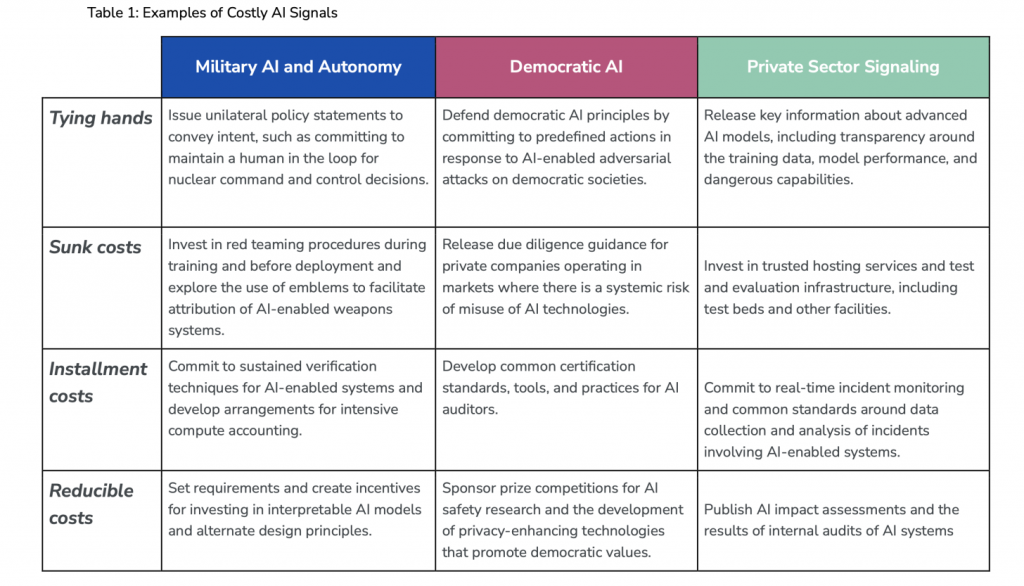

论文中的四个信号是束缚成本、沉没成本、分期成本和可减少成本。这些方法各不相同,从束缚手脚(通过政策或其他公告来限制公司,难以摆脱)到分期付款成本较高,初始成本较高(例如成本高昂的合规承诺),随着收益的增加,分期成本会随着时间的推移而减少。

在这方面,Toner 女士的论文特别关注了 OpenAI 围绕 GPT-4 模型推出所采取的行动。OpenAI 于 2023 年 3 月发布了 GPT-4,据该论文的作者称,虽然该模型本身是一项了不起的技术成就,但它与信号发送的相关性来自其补充文件。

论文中定义的昂贵的人工智能信号。图片:昂贵的人工智能信号/解码意图的示例

人工智能和昂贵的信号 – Andrew Imbrie Owen Daniels Helen Toner(乔治城大学安全与新兴技术中心)

这些文件包括一张系统卡,解释了 GPT-4 的风险,以及 OpenAI 在急于在市场上推出第一个 GPT-4 模型时如何减轻这些风险。作者表示,他们认为作为 OpenAI 安全承诺的沟通工具,它相对不成功。

该论文解释道:

虽然系统卡本身受到了有兴趣了解 GPT-4 风险状况的研究人员的好评,但作为 OpenAI 对安全承诺的更广泛信号,它似乎不太成功。造成这种意外结果的原因是该公司采取了其他行动,掩盖了系统卡的导入:最引人注目的是四个月前重磅发布的 ChatGPT。

研究人员随后将 OpenAI 的方法与其竞争对手 Anthropic 及其 Claude 平台使用的方法进行了比较。他们赞扬 Anthropic 决定推迟 Claude 的发射,以阻止“人工智能能力进步的速度”,并将这一决定定义为“代价高昂的克制信号”。

正如他们所说:

通过推迟 Claude 的发布,直到另一家公司推出类似功能的产品,Anthropic 表明它愿意避免 ChatGPT 的发布似乎引发的那种疯狂的偷工减料行为。Anthropic 通过利用分期付款成本或无法随时间抵消的固定成本来实现这一目标。在这项研究的框架中,Anthropic 通过阻止其模型提前发布并吸收未来潜在的收入损失,增强了其对人工智能安全承诺的可信度。本案的动机不是通过获得更广泛的市场份额来弥补这些损失,而是为了促进行业规范并为负责任的人工智能开发和部署的共同期望做出贡献。

《纽约时报》的报道称,论文发表后,奥尔特曼对霍尔特并不满意,他通过电子邮件向 OpenAI 员工表达了他的担忧。此外,不久之后发生了一个相当有趣的进展,OpenAI 的研究主管 Ilya Sutsekver 最初讨论是否将 Toner 赶出董事会。然而,令人惊讶的是,他随后选择了对抗奥特曼——这个决定几天后他就会后悔。